| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

- How Much Knowledge Can You Pack Into the Parameters of a Language Model?

- DST fewshot learning

- 정보처리기사 수제비

- 딥러닝기초

- few shot dst

- 모두의딥러닝

- SUMBT:Slot-Utterance Matching for Universal and Scalable Belief Tracking

- til

- From Machine Reading Comprehension to Dialogue State Tracking: Bridging the Gap

- 정보처리기사전공자합격후기

- 다이나믹 프로그래밍

- 자연어처리 논문 리뷰

- Zero-shot transfer learning with synthesized data for multi-domain dialogue state tracking

- DST zeroshot learning

- Python

- 데이터 합성

- 검색엔진

- 정보처리기사 책 추천

- 프로그래머스

- Few Shot Dialogue State Tracking using Meta-learning

- 정보처리기사전공자

- 2020정보처리기사필기

- Leveraging Slot Descriptions for Zero-Shot Cross-Domain Dialogue State Tracking

- 파이썬을 파이썬답게

- fasttext text classification 한글

- 백준

- dialogue state tracking

- nlp논문리뷰

- MySQL

- classification text

- Today

- Total

🌲자라나는청년

[NLP논문리뷰]How Much Knowledge Can You Pack Into the Parameters of a Language Model? 본문

[NLP논문리뷰]How Much Knowledge Can You Pack Into the Parameters of a Language Model?

JihyunLee 2021. 9. 6. 16:34제목 : HowMuchKnowledge Can You Pack Into the Parameters of a Language Model?

저자 : Adam Roberts, Colin Raffel, Noam Shazeer

발행년도 : 2020

paper : https://arxiv.org/abs/2002.08910

code : https://github.com/google-research/google-research/tree/master/t5_closed_book_qa

Review

QA모델에 대한 논문 중 google에서 출간한 논문.

기존의 QA task는 passage를 보여주고 이에 대한 답을 찾아가는 방식이었다. 그러나 이 논문은 passage를 보여주지 않고 질문 부터 한다.

즉 다양한 task에 대해 학습한 T5에게 "루즈벨트 대통령이 태어난 해는?" 이라는 질문을 한다면, T5는 위키피디아의 지식 없이도 1882이라고 답을 하는지 실험해 본 논문이다.

논문에서는 Passage를 보여주고 Passage안에서 답을 찾도록 한 방식을 Open book test, passage를 보여주지 않고 답을 찾도록 한 방식을 Closed book test라고 비유했다!

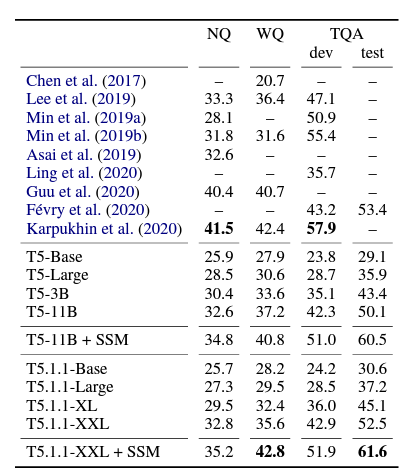

Experimetns

실험에는 Natural Question, WebQuestions, TriviaQA 데이터를 사용하였고, passage는 사용하지 않고, 질문-답만 사용해서 학습시켰다.

Result

여기서 T5.1.1 은 unlabeled data only로 학습된 T5를 의미한다. 놀랍게도, passage를 보여주지 않았음에도 SOTA의 성능을 달성한 Task들이 있었으며, 다른 데이터 셋에 대한 성능도 SOTA에서 크게 뒤쳐지지 않았다.